IGGI Logo Bild: Deutsches Museum

Digitale Technik- und Wissenskulturen

IGGI - Ingenieur-Geist und Geistes-Ingenieure

Die Debatten um „Künstliche Intelligenz“ (KI) sind auch hierzulande dominiert von übersteigerten Erwartungen und Ängsten. Doch welchem Nutzen, welchen Zielen sollte die KI-Forschung in Westdeutschland ursprünglich dienen? Wo war sie zunächst innerhalb der Wissenschaft verortet?

Inhalt

IGGI - Ingenieur-Geist und Geistes-Ingenieure: Eine Geschichte der Künstlichen Intelligenz in der Bundesrepublik Deutschland.

Gefördert von

Das Projekt (Förderkennzeichen 01IS19029) wird im Rahmen der Förderrichtlinie „Intelligente Systeme“ gefördert vom BMBF.

- Digitale Technik- und Wissenskulturen

Bearbeitet von

PD Dr. Rudolf Seising

PI: DFG-Projekt „ArtViWo“; PI: IGGI

Dr. Helen Piel

BMBF Forschungsprojekt "Eine Geschichte der KI in der BRD"Teilprojekt "Künstliche Intelligenz und Kognitionswissenschaft"

Florian Müller

BMBF Forschungsprojekt "Eine Geschichte der KI in der BRD"Teilprojekt "Sprachverarbeitung"

Dr. Dinah Pfau

DFG-Projekt „ArtViWo“

Jakob Tschandl

BMBF Forschungsprojekt "Eine Geschichte der KI in der BRD"Teilprojekt "Expertensysteme"

Projektbeschreibung

Das Projekt untersuchte, wie sich die KI-Forschung im Umfeld des deutschen Wissenschafts- und Innovationssystems entwickelte und schließlich zu einem auch international überaus erfolgreichen Teilgebiet der bundesdeutschen Informatik wurde. Neben der Auswertung des reichhaltigen Quellenmaterials nutzten wir Interviews mit ZeitzeugInnen, um die deutsche KI-Entwicklung in der Wissenschafts- und Technikgeschichte einzuordnen.

"Künstliche Intelligenz" (KI) dominiert zurzeit die Debatten

"Künstliche Intelligenz" (KI) dominiert zurzeit die Debatten in Wissenschaft und Technik, Politik, Wirtschaft, Kunst und medialer Öffentlichkeit. KI, das sind nicht nur autonome Fahrzeuge, Schachcomputer oder sprechende Roboter: KI ist auch eine wissenschaftliche Disziplin, in der mit Hilfe des Computers menschliche Intelligenz nachgeahmt und sogar Maschinen mit eigener 'Intelligenz' konstruiert werden sollen. Das Schlagwort KI steht für Forschungen über Entwurf, Verarbeitung und Kommunikation von Information in und durch Maschinen. Das alles sind Fähigkeiten, die die Intelligenzforschung gemeinhin dem Menschen zuschreibt.

Ingenieur-Geist und Geistes-Ingenieure

In dem Projekt IGGI arbeiteten wir die Geschichte der KI in der Bundesrepublik Deutschland auf, um das Verständnis der "KI" genannten Technologien zu fördern. Das Akronym "IGGI" weist darauf hin, dass einige frühe InformatikerInnen der Ansicht waren, das Programmieren sei eine Tätigkeit, die kein materielles Produkt hervorbringe, sondern abstrakte Konstrukte zur Problemlösung. Nachdem sich etwa Mitte der 1970er Jahre eine westdeutsche KI-Community formierte, warfen auch deren VertreterInnen die Frage auf, ob auch Computer denken können. Dann bestünde zwischen der Problemlösung durch Computerprogramme und jener durch den menschlichen Geist kein Unterschied. Das besagt die Computermetapher des Geistes, auf der die Kognitionswissenschaften beruhen.

In den 1980er Jahren differenzierten sich Teilgebiete aus, darunter das automatische Beweisen mathematischer Theoreme, die Bild- und Sprachverarbeitung oder Expertensysteme. Mit der Kognitionswissenschaft sind damit die fünf Teilgebiete genannt, die im Rahmen dieses Forschungsprojektes untersucht werden.

Zentrales methodisches Element war die Sicherung und Auswertung von Materialien in Vor- und Nachlässen sowie in breit angelegten Erinnerungen der noch lebenden PionierInnen. Diese wurden als Video-Aufnahmen archiviert und mit der Oral-History-Methode ausgewertet.

Wie wir dabei vorgegangen sind, können Sie in unserer Online-Ausstellung KI-Geschichte: Ein Making-Of ansehen.

Teilprojekte

Bild: Illustration Dinah Pfau

Automatisches Beweisen

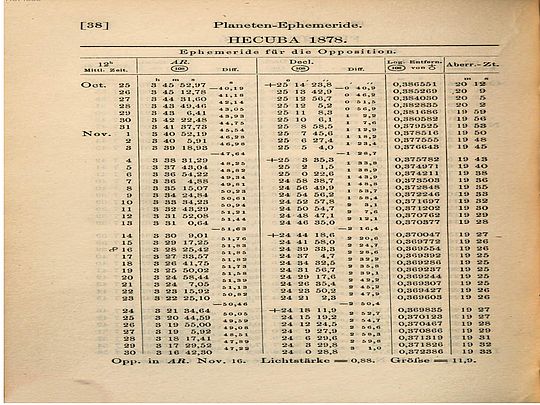

Eine der ältesten Anwendungen der KI ist das computerisierte bzw. computerunterstützte Beweisen mathematischer Sätze (Theoreme).

Damit ein mathematischer Satz als gültig angesehen werden kann, muss er mathematisch bewiesen werden. Einen Beweis zu suchen und ihn durchzuführen sind zwei verschiedene Aufgaben, denen sich MathematikerInnen stellen. Ein solcher Beweis erfolgt durch logische Schlussfolgerungen, mittels derer der Satz auf bereits als richtig geltende Sätze zurückgeführt wird. Bei der Suche nach einem Beweis hilft MathematikerInnen oftmals Erfahrung und Intuition. Bevor sie ihn durchführen können, werden sie dennoch ihre Beweisansätze häufig auch probieren und sukzessive korrigieren müssen. Können Computer mathematische Beweise suchen und führen?

Diese Fragen gehören zum Gründungsnarrativ der KI-Forschungen in den USA. Es beginnt mit einem von John McCarthy, Marvin Minsky, Claude Shannon und Nathaniel Rochester organisierten Treffen im Dartmouth College im Jahr 1956. Dort präsentierten Herbert Simon und Allen Newell, das von ihnen gemeinsam mit Cliff Shaw geschaffene Programm "Logic Theorist", das einige grundlegende Theoreme aus der Principia Mathematica von Russell und Whitehead bewies.

Dieses Teilprojekt untersuchte die ersten Entwicklungen des Automatischen Beweisens in der Bundesrepublik Deutschland. Ein erster Forscher auf diesem Gebiet war Gerd Veenker, der in Tübingen im Rechenzentrum angestellt war. In den 1960er Jahren entwickelte er für sein Mathematik-Diplom ein "Entscheidungsverfahren für den Aussagenkalkül der Formalen Logik und seine Realisierung in der Rechenmaschine", sowie danach für seine Dissertation ein "Beweisverfahren für den Prädikatenkalkül". In den 1970er Jahren setzte Veenker seine Untersuchungen zum Automatischen Beweisen als Professor in Bonn fort. In diesem Jahrzehnt arbeiteten auch die Mathematiker Wolfgang Bibel an der Technischen Universität in München und Jörg Siekmann an der University of Essex auf diesem Gebiet. Letzterer war nach England gegangen, um dort im Fach Artificial Intelligence zu promovieren. Als sich dieses neue Forschungsfeld auch in der Bundesrepublik Deutschland etablierte, forschte er dazu zunächst in Karlsruhe und später in Kaiserslautern. Es entstand eine Vielzahl von Theorembeweiser-Systemen, die in der logischen Programmierung, in der Programmsynthese und -verifikation genutzt wurden und die heute neben anderen in der Sammlung des "Theorem Prover Museums" (https://theoremprover-museum.github.io/) einsehbar sind.

Liste der geführten Zeitzeugengespräche und besuchten Archive

Bild: Illustration Dinah Pfau

Sprachverarbeitung

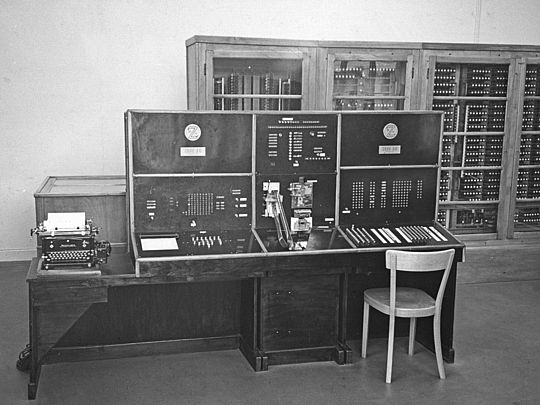

Im Forschungsfeld maschinelle Sprachverarbeitung wird zu der Frage geforscht, wie der Computer natürliche Sprache verarbeiten kann. Bekannte Anwendungsbeispiele sind maschinelle Übersetzung oder automatische Chat-Programme. In diesem Teilprojekt wurde die historische Entwicklung der maschinellen Sprachverarbeitung in der Bundesrepublik in den 1960er bis 1980er Jahren untersucht.

Die maschinelle Sprachverarbeitung etablierte sich Anfang der 1960er Jahre im Kontext der Linguistik in der Bundesrepublik als Forschungsfeld. Ziel war es zu diesem Zeitpunkt die Nutzung des Computers als Werkzeug für die linguistische Forschung zu etablieren. Mitte der 1970er Jahre, als Forschende begannen sich im Kontext der Etablierung der Künstlichen-Intelligenz-Forschung in der Bundesrepublik für sprachorientierte KI-Forschung zu interessieren, wandelte sich das Forschungsfeld. Der Fokus lag ab diesem Zeitpunkt nicht mehr alleinig auf linguistischer Forschung, er verschob sich hin zu stärker anwendungsorientierter Forschung mit dem Ziel eine funktionierende Mensch-Maschine-Kommunikation zu ermöglichen. Diese Veränderung des Forschungsschwerpunkts wurde durch einen Wandel der bundesrepublikanischen Forschungsförderung ab Mitte der 1970er Jahre gestützt, die eine verstärkte Anwendungsorientierung der Forschung forderte.

Im Zentrum der historischen Forschung in diesem Teilprojekt standen drei Fallbeispiele: das Projekt Hamburger Redepartner-Modell an der Universität Hamburg (1975-1981), wo an einem Dialogsystem gearbeitet wurde, der Sonderforschungsbereich 100 Elektronische Sprachforschung an der Universität des Saarlandes (1973-1986), wo vor allem zu maschineller Übersetzung geforscht wurde und die Arbeiten zur maschinellen Sprachverarbeitung am Institut für Deutsche Sprache (1964-1980), wo unter anderem ein Frage-Antwort-System entwickelt wurde.

Liste der geführten Zeitzeugengespräche und besuchten Archive

Bild: Illustration Dinah Pfau

Bildverarbeitung

Dieses Teilprojekt hat im Jahr 2020 begonnen, sich dem Thema "Bildverarbeitung" zu widmen. (Nicht zu verwechseln mit Computergrafik.) Die maschinelle Verarbeitung, Manipulation und Interpretation von Bild und Text als Informationsträgern, so hat sich schnell herausgestellt, fand in ganz verschiedenen Wissenschafts- und Gesellschaftsbereichen Anwendung (Medizin, Physik, Biologie, aber auch Nachrichtentechnik, Fernerkundung und viele mehr) und wurde unter verschiedenen Begriffen beforscht (Mustererkennung, Bildverarbeitung, Bildverstehen und weitere). Häufig, aber bei weitem nicht immer, wurden die dahinterstehenden Technologien auch als "KI" bezeichnet.

Warum aber hat man überhaupt angefangen, Bilder mit Maschinen auszuwerten? Und mit welchen Mitteln hat man das versucht? Inwiefern hat dies den Umgang mit und die Wirkung von diesen Bildern verändert? Fragen, wie diesen, widmete sich das Projekt exemplarisch anhand von zwei Fallstudien, die beide einen Zeitraum von etwa 20 Jahren abdecken. Die erste Fallstudie analysierte den Umgang mit Bildern im Zusammenhang mit den Experimentalpraktiken der Teilchenphysik am DESY und untersuchte ihre Implikationen für Ansätze in der Informatik (etwa 1964-1980). Die zweite Fallstudie befasste sich mit den technischen und epistemischen Verschiebungen in der Forschung an der Schnittstelle von Nachrichtentechnik und Kybernetik in Karlsruhe und untersuchte ihre Implikationen für spätere Ansätze der Mustererkennung (etwa 1951-1970).

Indem dieses Projekt maßgeblich auf Mikrostudien zweier Experimentalsysteme aufbaute, orientierte es sich an der Herangehensweise des Wissenschaftshistorikers Hans-Jörg Rheinberger. Auf diese Weise verknüpfte das Projekt Technik- und Wissenschaftsgeschichte und analysierte anhand Rheinbergers Theorie detailliert die epistemischen und technischen Bedingungen der Herstellung von Wissen in der Erforschung und mit der Anwendung technischer Systeme zur Auswertung und Interpretation von Bildern. Damit leistete es einen wichtigen Beitrag zur Diskussion um wissenschaftliche Wissensproduktion unter Bedingungen von Informations- und Kommunikationstechnologien, Automatisierung und Künstlicher Intelligenz.

Liste der geführten Zeitzeugengespräche und besuchten Archive

Als ein Beispiel damaliger Forschung finden Sie hier die Projekte DARVIN und BILDFOLGEN von Prof. Dr. Hans-Hellmut Nagel.

Bild: Illustration Dinah Pfau

Expertensysteme

In diesem Teilprojekt ging es um einen ersten Versuch kommerzieller Anwendung der Künstlichen Intelligenz.

Die Grundidee der sogenannten Expertensysteme war es, das Wissen von ExpertInnen, z. B. einer ÄrztInnen, in Form von Wenn-dann-Regeln in einem Computer zu hinterlegen. NutzerInnen sollte diesem System Fragen stellen. Das System würde dann verschiedene Suchstrategien und Methoden anwenden, um in der Wissensbasis nach Antworten auf diese Fragen zu suchen. Daher wurden Expertensysteme häufig auch als wissensbasierte Systeme bezeichnet.

Der Ursprung dieses Teilgebiets der KI wird auf das US-amerikanische System DENDRAL zurückgeführt, welches ab 1965 in Stanford entwickelt wurde. 1980 sorgten Berichte von einer erfolgreichen kommerziellen Anwendung eines Expertensystems in den USA für Aufsehen. Als 1982 Japan mit dem "Fifth Generation Computer Program" einen Schwerpunkt auf diese Technologie setzte, reagierten die USA und Europa mit umfassenden Förderprogrammen. So auch die Bundesregierung in Bonn. Es begann ein regelrechter "Hype" um die vielversprechenden neuen Expertensysteme, die für nicht wenige zum Inbegriff der Künstlichen Intelligenz in dieser Zeit wurden. Die staatliche Förderung animierte große Konzerne KI-Entwicklungsabteilungen zu gründen. Auch Großforschungseinrichtungen setzten Schwerpunkte auf die Expertensystemtechnologie. Mit dem konkreten Anwendungsbezug der Expertensysteme wuchs das Interesse der breiten Öffentlichkeit am Thema KI.

Als Anfang der 1990er Jahre aber absehbar wurde, dass das japanische "Fifth Generation Computer Program" die hochgesteckten Ziele nicht erreichen würde und kommerziell erfolgreiche Expertensysteme die Ausnahme blieben, fuhren Staat und Industrie ihre Investitionen wieder zurück.

Die Zusammenhänge von Wissenschaft, Wirtschaft, Politik und Medien bei dem Versuch, Expertensysteme zur ersten kommerziell erfolgreichen Anwendung der KI-Forschung zu verhelfen, wurde aus diskurstheoretischer Perspektive beleuchtet. Mit der praktischen Anwendung wurde zusätzlich zur technischen Fragen, auch entscheidend, wie die Allgemeinheit, Wirtschaft und Politik von dem Nutzen der Expertensystemtechnologie überzeugt werden konnte. Die dabei angewandten diskursiven Strategien wurden in diesem Teilprojekt herausgearbeitet.

Liste der geführten Zeitzeugengespräche und besuchten Archive

Bild: Illustration Dinah Pfau

Künstliche Intelligenz und Kognitionswissenschaft

KognitionswissenschaftlerInnen fragen, wie kognitive Prozesse (darunter Denken, Problemlösen oder Wahrnehmung) in natürlichen und technischen Systemen wie Menschen oder Computern funktionieren. Dazu kommen verschiedene Disziplinen zusammen, denen die Grundannahme gemein ist, dass Kognition eine Art der Informationsverarbeitung ist.

Ziel dieses Teilprojektes war die Erforschung der Entwicklung der dieses Forschungsfeldes in der Bundesrepublik Deutschland. Das Verhältnis dieser Forschungsrichtung zu der ebenfalls aufkommenden Künstlichen-Intelligenz-Forschung lieferte dabei einen Rahmen und Fokus: Beide dieser Forschungsrichtungen speisen sich aus teils denselben Entwicklungen der 1940er bis 1960er Jahre (bspw. Computerentwicklung und Informatik, Kybernetik, Kognitive Psychologie), nutzen verwandte Methoden (Kognitive Modellierung) und haben einen verwandten – je nach Position denselben – Forschungsgegenstand (natürliche und/oder technische kognitive Systeme).

Nach einer Übersicht über einige historische Wurzeln der Kognitionswissenschaft in den USA und in der Bundesrepublik Deutschland lag der Fokus für einen Großteil der Arbeit auf der Bundesrepublik in den 1980er Jahren. Dies war das Jahrzehnt, in dem die Kognitionswissenschaft in der westdeutschen Forschungslandschaft sichtbar wurde und Forschende sich zu vernetzen begannen. Zu Beginn fand dies hauptsächlich in kleineren, lokal und informell organisierten Arbeitskreisen und vereinzelten Projekten statt. Ab 1985 förderte schließlich die Deutsche Forschungsgemeinschaft drei Schwerpunktprogramme, in denen interdisziplinäre Projekte mit Forschenden aus der Psychologie, Informatik, Philosophie, Neurowissenschaft und Linguistik kognitionswissenschaftliche Fragestellungen beispielsweise rund um "Wissen" behandelten. Zwischen Kognitionswissenschaft und KI gab es während des gesamten Zeitraums personelle und thematische Überschneidungen und Anknüpfungspunkte. Unterschiedliche Forschende mögen dabei der einen oder der anderen Forschungsrichtung die übergeordnete Rolle zugesprochen haben. Generell lässt sich aber feststellen, dass kognitionswissenschaftliche Forschung stärker erklärungs-, KI-Forschung stärker anwendungsorientiert war.

Liste der geführten Zeitzeugengespräche und besuchten Archive

Veranstaltungen

Tandem Workshop mit dem Karlsruher Institut für Technologie (KIT) "Die frühe Geschichte der Künstlichen Intelligenz", Erster Teil, Karlsruhe, 17.-18.09.2020:

Ein erster Workshop zur gegenseitigen Vorstellung der beforschten Materialien (Manuskripte, Artefakte, Publikationen, Zeitzeugenberichte) und gemeinsamen Besprechung fruchtbarer Forschungsfragen und interessanter Perspektiven fand am 17. und 18. Sept. in Karlsruhe statt. Organisiert wurde der erste Workshop von dem Projekt "Die Zukunft Zeichnen – Technische Bilder als Element historischer Technikzukünfte in der frühen Künstlichen Intelligenz" der HEiKAexplore-Forschungsbrücke "Autonomous systems in the area of conflict between law, ethics, technology and culture" der Universität Heidelberg und des KIT.

Tandem Workshop mit dem Karlsruher Institut für Technologie (KIT) "Die frühe Geschichte der Künstlichen Intelligenz", Zweiter Teil, München, 20.-21.05.2021:

In einer Kombination aus Vorträgen zur Geschichte der Künstlichen Intelligenz und der Diskussion von im Vorfeld zirkulierten Texten wurden gemeinsam Ansätze erarbeitet. Dieses interdisziplinäre Vorhaben hat dabei nicht nur historische, sondern ausdrücklich auch philosophische sowie medien- und kulturtheoretische Ansätze zur Sprache gebracht.

Montagskolloquium des Deutschen Museums "Maschinen Denken – Geschichte, Gegenwart und Zukunft der Künstlichen Intelligenz", April bis Juli 2021:

Die internationale und interdisziplinäre Vortragsreihe"Maschinen Denken – Geschichte, Gegenwart und Zukunft der Künstlichen Intelligenz" bot mit ihren sieben Vorträgen eine integrierte Perspektive auf Künstliche Intelligenz. Die Reihe im Sommersemester 2021 wurde gemeinsam vom Forschungsinstitut für Wissenschafts- und Technikgeschichte, Deutsches Museum, im Rahmen seines traditionellen "Montagskolloquiums", der STS-Gruppe an der European New School of Digital Studies, EUV, dem Münchner Zentrum für Wissenschafts- und Technikgeschichte (MZWTG), TUM, und der Philosophy of Computing Group, ICFO, Warsaw University of Technology, veranstaltet.

Internationale Tagung "AI in Flux – Histories and Perspectives on Artificial Intelligence", online, 29.11.-01.12.2021:

Wir versammelten Wissenschafts- und TechnikhistorikerInnen, PhilosophenInnen und InformatikerInnen, um die Veränderungen und die Verbreitung der Idee, dem Forschungsfeld und der Technologie "Künstliche Intelligenz" zu diskutieren, seitdem sie ihren ursprünglichen US-amerikanischen Kontext verlassen hat. Unsere 2 ½-tägige Online-Konferenz bestand aus zwei Teilen: einem halben Tag mit Diskussionen mit KI-Pionieren und zwei Tagen mit Vorträgen aus interdisziplinären Perspektiven zur Geschichte der künstlichen Intelligenz.

Tagung "Was war Künstliche Intelligenz? Konturen eines Forschungsfeldes 1975-2000 in Deutschland", Berlin, 15.-16.05.2022

Eingeladen zur dreitägigen Veranstaltung waren sowohl ProtagonistInnen der west- und ostdeutschen zeitgenössischen KI-Entwicklung als auch ForscherInnen, die die unterschiedlichen Themengebieten der Künstlichen-Intelligenz-Forschung und -Entwicklung aus geschichts-, kultur- und medienwissenschaftlicher Perspektive einordneten. Die Konferenz ging auf Initiative der Fachgruppe "Informatik- und Computergeschichte" zurück, die innerhalb der Gesellschaft für Informatik (GI) die historischen Aspekte der Disziplin in Ausstellungen, Museumskonzepten, Vorträgen und nun dieser Konferenz bearbeitet.

Tagung "(Er)Zeugnisse des Digitalen – Unsichtbares sichtbar machen", Bonn, 02.-03.05.2022

Während unserer Tagung "(Er)Zeugnisse des digitalen im Museum! diskutierten VertreterInnen von Universitäten und Museen im Deutschen Museum Bonn Herausforderungen des Umgangs mit Software als Artefakt im musealen Kontext.

Jahrestagung der Gesellschaft für Wissenschafts-, Medizin- und Technikgeschichte "Mensch – Maschine – Mobilität", Ingolstadt, 13.-15.09.2023

Die von uns zusammen mit dem Deutschen Medizinhistorischen Museum Ingolstadt organisierte Jahrestagung widmete sich der historischen Betrachtung der Themenfelder "Mensch und Maschine", "Maschine und Mobilität", "Mobilität und Mensch" sowie deren Übergängen und Abgrenzungen.

Abschlussveranstaltung des IGGI-Projektes, München, 15.12.2023

Am 31.12.2023 endete die Förderung des IGGI-Projektes durch das Bundesministerium für Bildung und Forschung. Dazu luden wir KollegInnen, FreundInnen, FörderInnen und ZeitzeugInnen ein. Zum Abschluss sprach die kanadische KI-Historikerin Stephanie Dick und wir resümierten selbst über unsere Forschung der vergangenen Jahre. Anschließend sprach der Librettist und Stückdramaturg Georg Holzer über die künstlerische Aufbereitung wissenschaftshistorischer Forschung in Form einer Oper am Beispiel Alan Turings. Abgerundet wurde der Abend mit einer Kunstperformance des Opernkollektivs DIVA.

Alle Programmpunkte des Abends gibt es hier als Video:

Einführung durch Ulf Hashagen, Leiter des Forschungsinstituts des Deutschen Museums und Rudolf Seising, Leiter des Forschungsprojektes IGGI

Vortrag von Stephanie Dick: "Castles in the Sky": Reflections on the Mechanical Inexhaustibility of Mathematics

Vortrag von Helen Piel und Rudolf Seising: Perspektiven auf die Anfänge bundesdeutscher KI-Forschung

Einblicke in die Oper "Turing" mit Georg Holzer

Kunstperformance des Opernkollektivs DIVA und Danksagung

Publikationen und Vorträge

Liste aller Publikationen des IGGI-Projektteams

Im Dezember 2023 erschien ein Sammelband mit ersten Ergebnissen unserer Forschung in der Reihe "Deutsches Museum Studies". Diesen können Sie hier herunterladen: Zum Sammelband

Liste aller Vorträge des IGGI-Projektteams

Der Ausstellungsdienst des Deutschen Museums hat im Dezember 2020 zwei M*Vlog-Beiträge mit Rudolf Seising zum Thema "Die Geschichte der Künstlichen Intelligenz in der Bundesrepublik Deutschland" produziert und im Januar 2021 veröffentlicht: