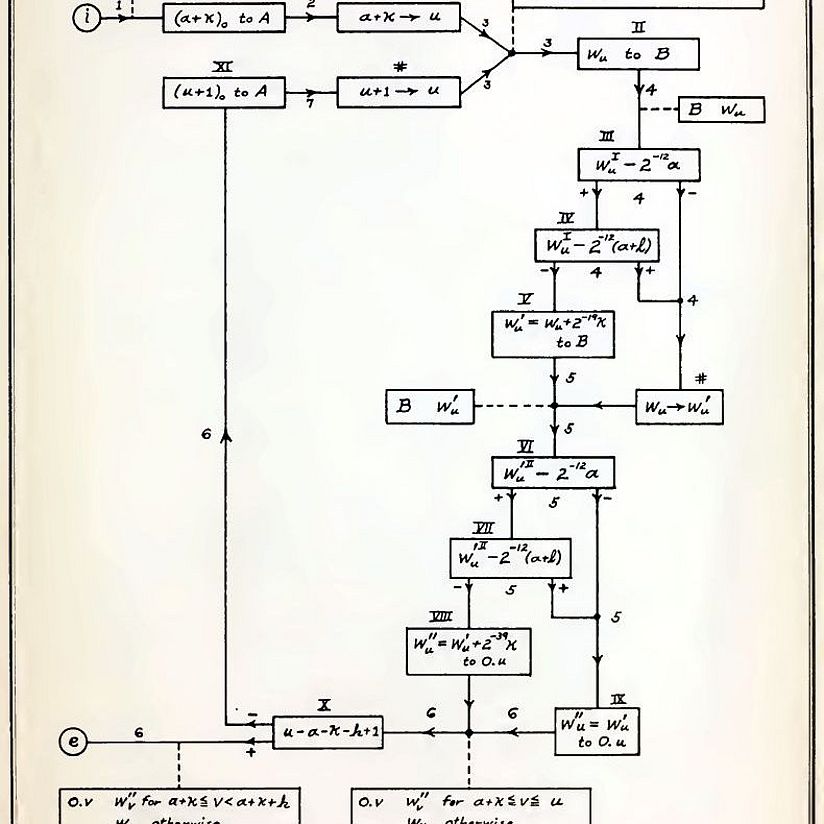

Hermann H. Goldstine und John von Neumann: Flow chart of planning and coding of problems for an electronic computing instrument, 1947. Bild: Archiv.org, public domain | Goldstine, Herman Heine, and John Von Neumann

Digital cultures of technology and knowledge

Algorithmische Wissenskulturen

Wie hat der Computer die Wissenschaft revolutioniert? Die „Algorithmisierung“ der Wissenschaft war nicht einfach eine Folge des Computereinsatzes in den verschiedenen Disziplinen, sondern ist ein komplexer Prozess, indem sich neue soziale Netzwerke zwischen Maschinen, Menschen und Arbeitsroutinen entwickeln.

Inhalt

Algorithmische Wissenskulturen – Der Einfluss des Computers auf die Wissenschaftsentwicklung.

- Digital cultures of technology and knowledge

- Digitale Technik- und Wissenskulturen

- Mathematik und Informatik

Projektbeschreibung

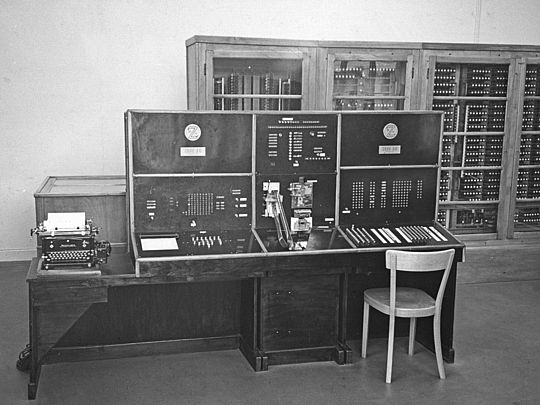

Obwohl es längst zu einem Allgemeinplatz geworden ist, dass der Computer die Wissenschaften revolutioniert hat, ist dieser für die Entwicklung von Wissenschaft und Technik grundlegende historische Prozess von der Wissenschaftsgeschichte bisher kaum untersucht worden. Das Projekt analysiert, welchen Unterschied der Computer für die Wissenschaftspraxis und das Agenda-Setting in den einzelnen Disziplinen machte und wie der Einsatz von computerbasierten algorithmischen Methoden das wissenschaftliche, technische und medizinische Handeln veränderte.

Grundlegende These ist, dass (soziale) Netzwerke zwischen den Wissenschaftlern und Wissenschaftlerinnen und ihren Untersuchungsobjekten mit den Computern, der Software und dem „Computer-Personal“ sowie die Herausbildung von formalisierten Arbeitsroutinen eine herausragende Bedeutung für die „Algorithmisierung“ der Wissenschaft besaßen. Erste Feldstudien zeigen, dass keineswegs ein gleichförmiger Prozess einer „Computer Revolution“ über alle Wissenschaften und alle Länder hinweg zog, sondern dass entgegen dem bisher in der Wissenschaftsgeschichte und Wissenschaftstheorie gängigen Bild einer in allen Wissenschaften allgegenwärtigen Computersimulation unterschiedlichen Formen von Veränderungsprozessen sowie verschiedenartige Auswirkungen auf einzelne Disziplinen vorlagen. Zudem scheint die durch den Einsatz von computerbasierten algorithmischen Methoden in bestimmten Bereichen der Wissenschaft und Technik erzeugte „Erkenntnis-Revolution“ einen „qualitativen Schwund“ in der Falsifizierbarkeit wissenschaftlicher Modelle und Theorien erzeugt zu haben, womit eine Art „digitaler Pandora-Büchse“ geöffnet wurde.

Teilprojekte

IGGI Logo Bild: Deutsches Museum

Mathematical Statistics versus Machine Learning – The Influence of the Computer on the Development of Two-Cultures of Data Analysis.

In den letzten Jahrzehnten des 20. Jahrhunderts etablierten sich zwei unterschiedliche Zugangsweisen zur Analyse komplexer Prozesse im Wissenschaftssystem: Aus der Statistik hatte sich die sogenannte Datenanalyse entwickelt; dabei gingen die Statistiker von der Annahme aus, dass ihre Daten durch ein stochastisches Datenmodell generiert wurden, für das eine Wahrscheinlichkeitsverteilung zu schätzen war. Aus den Forschungen zur Artificial Intelligence hatte sich das Gebiet des Maschinellen Lernens etabliert. Dabei nahmen dessen Anhänger an, dass die Daten durch einen komplexen, aber völlig unbekannten „Mechanismus“ erzeugt werden. Ohne ein strukturiertes Verständnis der vorliegenden Prozesse werden bei diesem Zugang mit Hilfe von Lernalgorithmen zukünftige Ergebnisse vorhergesagt. Dieses Projekt ist eine Studie zur Geschichte der Disziplinen „Statistik“ und „Maschinelles Lernen“ im 20. Jahrhundert. Es fragt nach den historischen Entwicklungen der beiden „Kulturen“ statistischer Modellierung in ihren jeweiligen wissenschaftlichen Disziplinen und nach den epistemologischen Unterschieden.

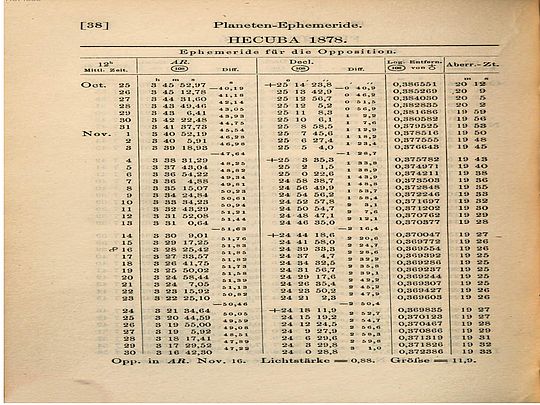

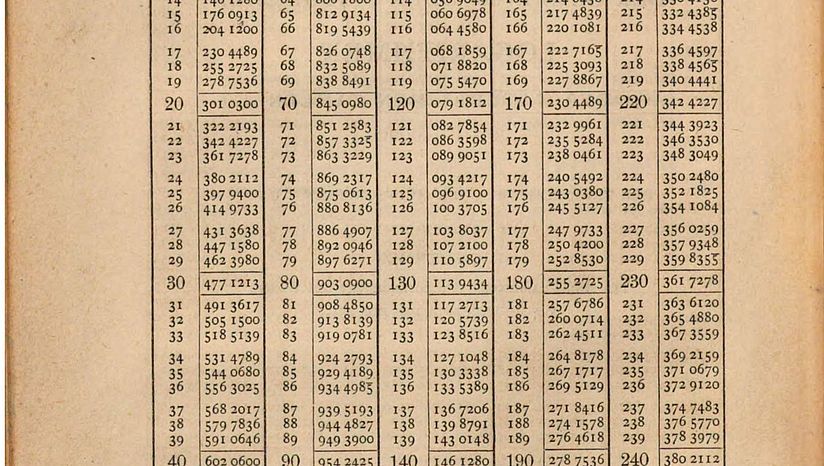

Logarithmentafeln waren bis weit ins 20. Jahrhundert hinein das Rechenhilfsmittel der Wahl, wie Carl Bruhns‘ 1870 erschienenes „Neues logarithmisch-trigonometrisches Handbuch auf 7 Decimalen“ Bild: C. C. Bruhns: Neues logarithmisch-trigonometrisches Handbuch auf 7 Decimalen. Leipzig: Tauchnitz, 1870 [Digitalisat Bayerische Staatsbibliothek]

Rechnen als Kunst und Wissenschaft: „Scientific Computing“ in der deutschen Astronomie 1870–1960.

Das Forschungsprojekt untersucht die Entwicklung des Rechnens in der deutschen Astronomie 1870–1960. Das „wissenschaftliche Rechnen“ wird dabei (neben Beobachtung und Theorie) als dritte grundlegende Forschungsmethodologie der Astronomie analysiert, die schon vor der Erfindung des Computers sowohl für die Interpretation der Beobachtungsergebnisse als auch für die Theorieentwicklung unentbehrlich war. Dabei wird ein vergleichender Blick auf andere Wissenschaftssysteme sowie auf die Entwicklung des „Rechnens“ in anderen Disziplinen geworfen. Es ist eine umfassende Monografie in Arbeit, die 2022/23 erscheinen soll.

Veröffentlichungen

- Seising, Rudolf: Warren Weaver’s “Science and Complexity” revisited. In: Seising, Rudolf; Sanz, Veronica (eds.): Soft Computing in Humanities and Social Sciences (Studies in Fuzziness and Soft Computing, Vol. 273) Berlin, Heidelberg [et al.]: Springer 2012, S. 55–87.

- Hashagen, Ulf: The Computation of Nature, Or: Does the Computer Drive Science and Technology? In: Bonizzoni, Paola; Brattka, Vasco; Löwe, Benedikt (eds.): The Nature of Computation: Logic, Algorithms, Applications. Berlin, Heidelberg: Springer 2013, S. 263–270.

- Inthorn, Julia; Tabacchi, Marco Elio; Seising, Rudolf: Having the Final Say: Machine Support of Ethical Decisions of Doctors. In: Pontier, Matthijs; van Rysewyk, Simon (eds.): Machine Medical Ethics. Basel: Springer 2015 (Intelligent Systems, Control and Automation: Science and Engineering Vol. 74), S. 181–206.

- Inthorn, Julia; Seising, Rudolf (Hg.): Digitale Patientenversorgung. Zur Computerisierung von Diagnostik, Therapie und Pflege. Bielefeld: transcript (Medical Humanities 3) [erscheint 2021].

- Hashagen, Ulf; Seising, Rudolf (Hrsg.): Algorithmische Wissenskulturen? Der Einfluss des Computers auf die Wissenschaftsentwicklung. Cham: Springer [erscheint 2021].

Veranstaltungen

- Modellieren, Simulieren, Muster finden: Historische, anthropologische und philosophische Reflexionen; Sektion auf der Jahrestagung der DGGMNT, Lübeck, 18.09.2016

Organisation: PD Dr. Ulf Hashagen, PD Dr. Rudolf Seising - Algorithmische Wissenskulturen? Der Einfluss des Computers auf die Wissenschaftsentwicklung; Workshop 12.-14. Oktober 2017, Deutsches Museum München

Organisation: PD Dr. Ulf Hashagen, PD Dr. Rudolf Seising - Wer (oder was) versorgt uns(ere) Patienten? Computerisierung von Diagnostik, Therapie und Pflege. Interdisziplinärer Workshop zur historisch-philosophisch-soziologisch-juristischen und ethischen Reflexion der Computerisierung in Bereichen der Medizin und Pflege, 8.11. –10.11.2018

Organisation: Rudolf Seising, Julia Inthorn (JGU Mainz)