Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

KI: Fundamente

Grundlagen der Künstlichen Intelligenz erleben!

Wie ist es Menschen gelungen, Computer zu lernenden Maschinen zu machen? Was sind die Grundlagen der Künstlichen Intelligenz? Antworten auf diese fundamentalen Fragen bietet der Bereich »KI:Fundamente«. Die Funktionsweise Künstlicher Neuronaler Netze, aber auch Methoden des Bestärkendes Lernens (Reinforcement Learning) stehen in diesem Erlebnisraum im Mittelpunkt. Hier erleben Besucherinnen und Besucher die Grundlagen von KI, trainieren einfache neuronale Netze und sehen einem Künstlichen Neuronalen Netz beim »Denken« zu. Maschinelles Lernen kann hier auf informative und stets unterhaltsame Weise ausprobiert werden.

Einführung in den Erlebnisraum KNN

Wie Convolutional Neural Networks sehen

Künstliche neuronale Netze kann man nicht sehen und auch nicht anfassen. Sie sind nur Programmcode in einem Computer. Um diese Technologie im Museum nachvollziehbar präsentieren zu können, braucht es einen wahren »Kunst«-griff. Dieser gelang in Zusammenarbeit mit dem Ars Electronica Futurelab in Linz an der Donau: eine der weltweit führenden Institutionen für elektronische Medienkunst.

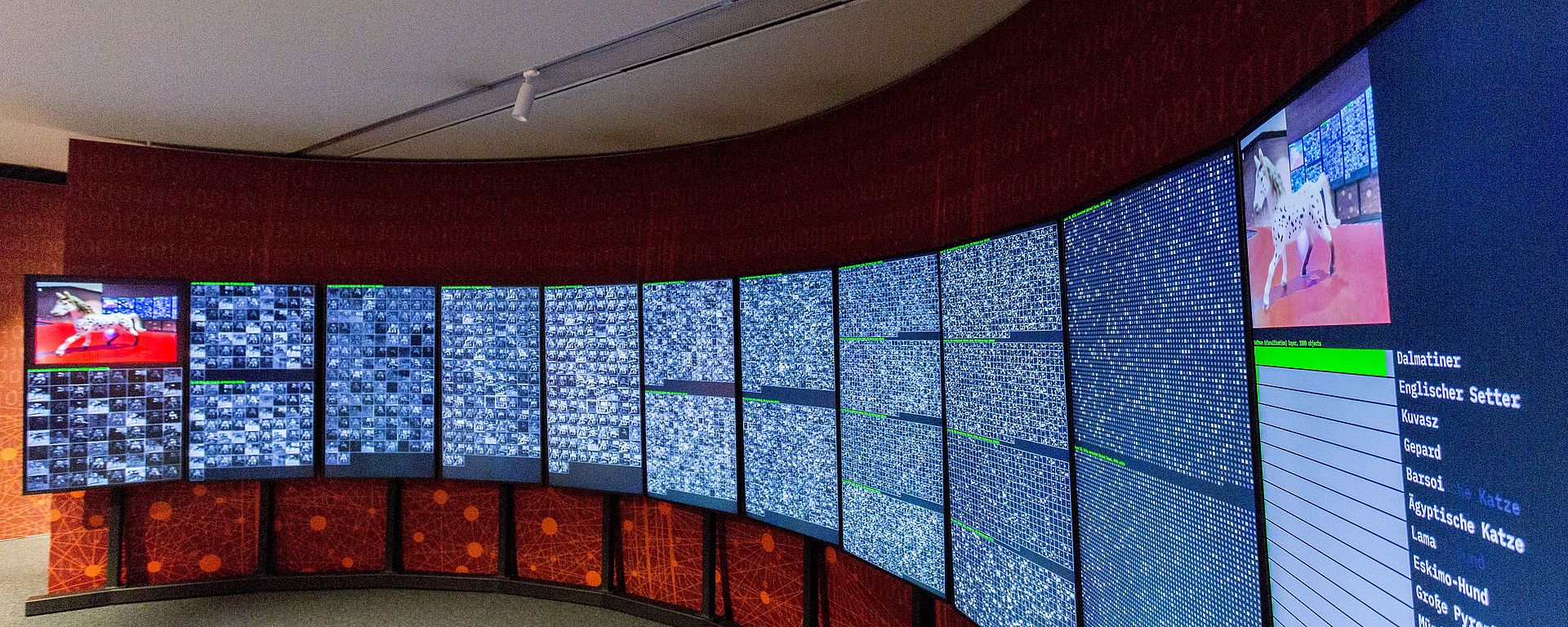

Herzstück des Erlebnisraumes ist daher eine eindrucksvolle Großinstallation, die den »Denkvorgang« eines vielschichtigen neuronalen Netzes sichtbar macht. Hier kann ein Bilderkennungssystem über eine Kamera mit verschiedenen Objekten konfrontiert werden. Auf elf Großmonitoren lässt sich nun verfolgen, wie die KI die Informationen verarbeitet: mit teilweise verblüffenden Ergebnissen! So wird auf unterhaltsame Weise deutlich, was sich hinter dem Begriff »Deep Learning« verbirgt.

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Neuronale Netze verstehen und trainieren

Unkonventionelle, aber auch nachdenklich stimmende Anwendungsbeispiele trainierter neuronaler Netze runden den Erlebnisraum ab. Hier geht es um die Kunst der »richtigen« Farbkombination. Die Besucherinnen und Besucher können ein einfaches künstliches neuronales Netzwerk in Echtzeit trainieren und sich so mit dessen prinzipieller Funktionsweise vertraut machen. Ziel ist es, dem Netzwerk beizubringen ob weiße oder schwarze Schrift auf zufällig generierten Hintergrundfarben für uns Menschen besser lesbar ist.

An einer weiteren Demonstration komponiert zum Beispiel eine KI die Werke Beethovens, Schumanns oder Bachs weiter.

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Explainable AI – Worauf achtet eine KI?

Die KI dieser Demonstration ist auf das Erkennen von Bildinhalten trainiert. Hier wird veranschaulicht, auf welche Bildbestandteile eine KI »achtet« und auf welche wir Menschen. Markiert die Bereiche, die für euch entscheidend sind und vergleicht das Ergebnis.

Diese Demonstration wurde vom Bundesamt für die Sicherheit in der Informationstechnik, Annika Rüll und Carola Plesch, konzipiert und umgesetzt.

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Pix2Pix: GANgadse

Gleichsam als leicht verdauliches Dessert steht noch eine ganz besondere KI-Anwendung auf unserem Programm, die aus allem, was Sie auf den Bildschirm malen, immer eine Katze macht. KI = Katzen-Intelligenz? Lassen Sie sich überraschen!

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Exploration vs. Exploitation – Erkunden oder Ausbeutung

»Exploration vs. Exploitation« ist ein zentrales Konzept der Künstlichen Intelligenz. An zwei Demonstrationen kann dieses Konzept nachvollzogen werden. Es ermöglicht das Lernen in unbekannten Umgebungen, in denen kein Vorwissen vorhanden ist. Zunächst erkundet die KI nach dem Zufallsprinzip ihre Umgebung, um mögliche Lösungen für ein Problem zu testen. Wenn diese gefunden sind, liefern sie ein Basiswissen, um die optimale Lösung zu finden. Es ist jedoch wichtig, ein gewisses Gleichgewicht zwischen Erkundung und Ausbeutung zu wahren: Wie oft sollten neue Lösungen getestet werden? Wie viel von den Erkenntnissen aus der ursprünglichen Strategie wird genutzt, bevor man zu einer anderen Aktion oder Strategie übergeht?

Die Demonstrationen sind in Kooperation mit der IMAGINARY gGmbH entwickelt worden.

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Gradient Descent – Lernen aus Fehlern

Diese Station bietet eine inhaltliche Ergänzung zur Funktionsweise Künstlicher Neuronaler Netze. Hier ist eine der wichtigsten KI-Methoden als actionreiches Arcade-Game inszeniert: Wie lernt eine KI durch Versuch und Irrtum Fehler zu minimieren?

Die Demonstrationen sind in Kooperation mit der IMAGINARY gGmbH entwickelt worden.

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Reinforcement Learning – Bestärkendes Lernen

Eine KI, die »Reinforcement Learning« verwendet, lernt durch Versuch und Irrtum. Sie interagiert direkt mit ihrer Umgebung, ähnlich wie auch Menschen und Tiere lernen. In der Demonstration versucht zum Beispiel ein Roboter, einen Weg durch ein Labyrinth zu finden. Besucherinnen und Besucher können ihm beim Lernen helfen, indem sie Belohnungen platzieren und sein Verhältnis von Erkundung zu Ausbeutung ändern.

Die Demonstrationen sind in Kooperation mit der IMAGINARY gGmbH entwickelt worden.

Bild: Deutsches Museum | Eric Alexander Lichtenscheidt

Kritzel Kommando

An dieser Station versuchen drei KIs handgeschriebene Zahlen zu erkennen. Nachdem eine Zahl auf das Touchfeld geschrieben wird, können die Besucher und Besucherinnen sehen, wie drei unbterschiedlich gut trainierte KIs gleichzeitig versuchen, die Zahl zu erkennen. Die KIs wurden mit 10, 100 oder 3.000 Beispielzahlen trainiert. Je besser die KI trainiert ist, desto besser erkennt sie die Zahl.

Die Demonstration ist entstanden an der Technischen Hochschule Köln – Modul Innovationsmanagement; entwickelt von Studierenden der Masterstudiengänge Green Building Engineering (M. Sc.) und Maschinenbau (M. Sc.). Matthias Beeck, Till Suchardt, Marlon Weiler, Saskia Weinert, Vivienne Weis